La prévision technologique est un processus systématique utilisé pour prédire le futur développement, l’adoption et l’impact des technologies. Diverses méthodes et techniques sont employées pour anticiper les tendances technologiques, aidant ainsi les organisations à prendre des décisions éclairées et à planifier pour l’avenir.

Contenus de la page

ToggleOverview des méthodes de prévision technologique

Extrapolation de Tendances : Cette méthode consiste à étendre les tendances actuelles dans le futur. Elle repose sur l’hypothèse que les modèles historiques se poursuivront, offrant un moyen direct de projeter les développements futurs. Bien que simple et facile à appliquer, surtout lorsque les données historiques sont fiables, cette méthode suppose une progression linéaire, ce qui peut ne pas saisir les perturbations soudaines ou les changements de paradigme.

Opinion d’Experts et Méthode Delphi : Cette approche implique de recueillir les opinions d’experts du domaine. La méthode Delphi collecte et synthétise de manière itérative les opinions des experts pour converger vers une prévision consensuelle. Elle tire parti des insights des experts, ce qui est particulièrement utile pour les technologies émergentes disposant de peu de données historiques. Cependant, elle reste vulnérable aux biais, et la qualité des prévisions dépend de l’expertise et de la diversité des experts impliqués.

Feuille de Route Technologique : Cet outil de planification stratégique offre une représentation visuelle de l’évolution des technologies dans le temps. Il identifie les jalons clés, les dépendances et les développements futurs potentiels. Il aide à aligner le développement technologique avec les objectifs organisationnels, favorisant la planification stratégique. Néanmoins, il peut avoir du mal à prendre en compte les facteurs externes imprévisibles et les innovations perturbatrices.

Analyse des Impacts Croisés : Cette approche examine les relations et interactions entre différents facteurs pour identifier l’impact potentiel des changements dans un domaine sur les autres. Souvent utilisée pour évaluer les implications de plusieurs développements technologiques, elle fournit une compréhension plus nuancée des interdépendances entre les facteurs. Sa complexité augmente avec le nombre de facteurs considérés, et son exactitude dépend de la qualité des données.

Modèle de Diffusion de Bass : Principalement utilisé pour prévoir l’adoption de nouvelles technologies sur un marché, ce modèle considère l’influence des innovateurs et des imitateurs dans le processus de diffusion. Il est utile pour estimer les modèles d’adoption et la saturation du marché, mais repose sur des hypothèses concernant l’influence des différentes catégories d’utilisateurs.

Analyse de la Courbe en S Technologique : Cette méthode examine le cycle de vie d’une technologie, dépeignant sa croissance, sa maturité et son déclin éventuel. Elle aide à comprendre le rythme d’adoption et le potentiel pour les technologies perturbatrices. Elle fournit des insights sur la trajectoire de la technologie et le point de saturation, mais suppose un cycle de vie prévisible, ce qui peut ne pas tenir pour les technologies évoluant rapidement.

Modélisation Basée sur les Agents : Implique de simuler les interactions d’agents individuels ou d’entités au sein d’un système pour observer les motifs émergents. Utilisée pour comprendre les systèmes complexes et prévoir leur comportement, cette méthode permet de modéliser des interactions complexes et des dynamiques non linéaires. Elle nécessite cependant des données détaillées et des ressources informatiques, et l’exactitude dépend de la fidélité du modèle aux dynamiques du monde réel.

Extrapolation des tendances

L’extrapolation des tendances est une méthode largement utilisée pour prévoir les évolutions futures. En exploitant les données historiques, il suppose que les tendances et les taux de croissance existants se poursuivront de manière prévisible. Essentiellement, l’extrapolation de tendance consiste à projeter la tendance actuelle vers le futur.

Bien que cette méthode soit simple et offre des informations précieuses pour les prévisions à court terme, elle suscite également son lot de critiques, en particulier lorsqu’elle est appliquée aux prévisions à long terme. Cette analyse approfondit les subtilités de l’extrapolation des tendances, en examinant ses méthodologies, ses applications, ses avantages et ses limites.

À la base, l’extrapolation des tendances consiste à étendre les tendances actuelles des données vers le futur. Elle repose sur l’idée que les modèles persistant dans les données historiques peuvent donner un aperçu du comportement futur. Cette méthode est généralement appliquée à l’aide d’outils et de techniques statistiques pour dériver des valeurs futures basées sur des modèles historiques.

L’extrapolation linéaire suppose un taux de croissance constant, ce qui la rend adaptée à la prévision d’événements dans un futur proche où des changements substantiels du taux de croissance sont peu probables. L’extrapolation non linéaire, en revanche, reconnaît que les taux de croissance peuvent changer et est souvent utilisée dans des scénarios comportant des tendances cycliques ou des facteurs connus susceptibles d’affecter la croissance.

De nombreuses tendances, en particulier dans des secteurs comme la vente au détail ou le tourisme, comportent des composantes saisonnières. L’ajustement pour tenir compte de la saisonnalité implique d’identifier et de prendre en compte ces fluctuations répétées, en s’assurant que la tendance extrapolée n’est pas faussement représentative en raison des variations saisonnières.

L’extrapolation moderne des tendances implique souvent des solutions logicielles capables de traiter de grandes quantités de données et d’utiliser des algorithmes avancés pour prédire les valeurs futures. L’analyse de séries chronologiques, les modèles de régression et l’apprentissage automatique peuvent aider à affiner les prévisions extrapolées.

L’extrapolation des tendances constitue un outil fondamental dans le monde de la prévision, offrant une approche simple pour prédire les évolutions futures sur la base de modèles historiques. Sa simplicité, sa rentabilité et sa fiabilité pour les prévisions à court terme en font un choix privilégié par de nombreux professionnels de divers secteurs.

Cependant, ses hypothèses inhérentes et ses pièges potentiels nécessitent une approche équilibrée, en la combinant souvent avec d’autres méthodes de prévision pour obtenir une vision plus complète. À une époque où les données déterminent les décisions, l’extrapolation des tendances reste un outil analytique crucial. Pourtant, comme pour toute méthode, son utilisation efficace nécessite de comprendre ses atouts, ses limites et le contexte dans lequel elle est appliquée. Dans le paysage en constante évolution du monde moderne, un mélange de données historiques, d’outils analytiques avancés et de connaissances d’experts garantit que nous abordons l’avenir avec prudence et prévoyance.

Opinion d'Experts et Méthode Delphi

Un premier questionnaire, contenant une question très générale, est envoyé à l’ensemble des experts-es. Ceux-celles-ci doivent ensuite le retourner rempli à l’équipe de chercheurs-es qui construira le questionnaire suivant en fonction des réponses obtenues dans le premier. Le processus continue jusqu’à ce que l’équipe obtienne un consensus significatif par rapport aux réponses. Trois questionnaires sont en général envoyés.

L’enquête Delphi suit alors généralement diverses étapes :

1. Former une équipe (groupe de pilotage) pour entreprendre et contrôler l’enquête Delphi. Le groupe de pilotage va aussi délimiter la zone d’étude Identification et formulation du problème à l’étude

2. Des experts (ou informateurs clé) sont sélectionnés, le groupe d’experts pouvant aller de 5 à 15 personnes

3. Le questionnaire du 1er tour est élaboré et envoyé aux intéressé-e-s après avoir été testé (pour enlever les ambiguïtés, les imprécisions, etc.)

4. Les questionnaires remplis sont traités et les réponses analysées : des statistiques sont élaborées ou des contenus organisés

5. Un 2ème questionnaire est créé avec de nouvelles questions qui permettent d’approfondir la thématique ou de vérifier. Le deuxième questionnaire sert à préciser, modifier ou encore justifier le jugement initial des expert-e-s. ce questionnaire est à nouveau envoyé

6. Les questionnaires remplis sont traités. Des statistiques ou des catégories thématiques sont élaborées, sur la base des réponses

7. Lorsqu’un consensus est trouvé ou la saturation est atteinte, le processus s’arrête. Généralement, ce consensus est trouvé après trois questionnaires

8. Une fois le consensus trouvé ou la saturation atteinte, un rapport final de résultats est élaboré par le groupe de pilotage et acheminé au/à la requérant-e

Le premier questionnaire comprend une question plutôt générale, ce qui permet aux expert-e-s de s’exprimer globalement. Le second questionnaire a pour but de revoir les priorités définies dans le premier, de les clarifier et de les classer selon un ordre d’importance. Ces réponses sont alors résumées et retournées aux experts-es dans un troisième questionnaire. Ils doivent alors prendre position par rapport aux réponses reformulées. Le processus s’arrête généralement à ce moment. Un consensus autour des questions à développer est alors trouvé.

Un des avantages de cette méthode est de pouvoir travailler avec des expert-e-s géographiquement dispersés sans qu’il n’y ait d’influence entre elles. Elle évite les effets d’influence qui peuvent se créer durant les face-à-face d’expert-e-s et garantit l’anonymat.

Feuille de route technologique

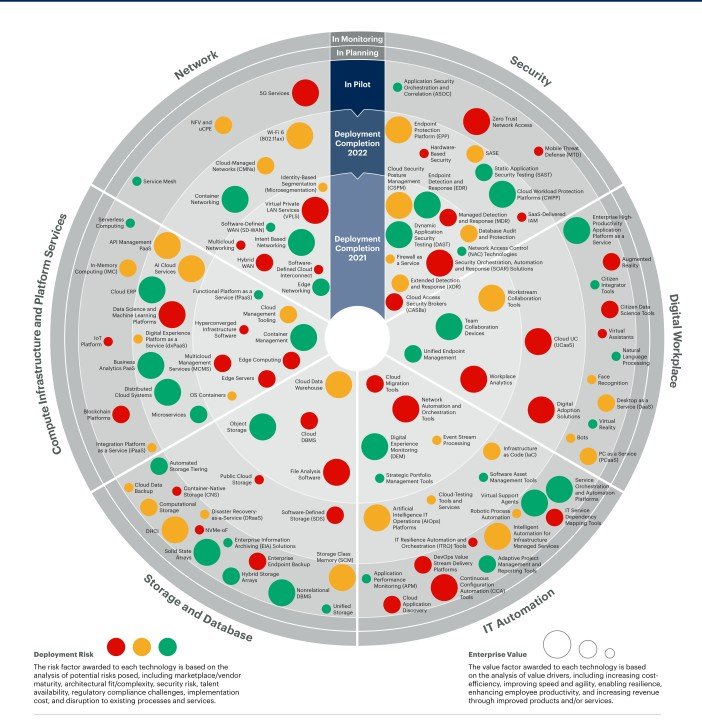

Une feuille de route technologique aide les équipes à documenter la justification de quand, pourquoi, comment et quelles solutions technologiques peuvent aider l’entreprise à aller de l’avant.

D’un point de vue pratique, la feuille de route devrait également décrire les types d’outils pour lesquels il est préférable de dépenser de l’argent et le moyen le plus efficace d’introduire de nouveaux systèmes et processus.

La feuille de route peut également vous aider à connecter la technologie dont l’entreprise a besoin avec ses objectifs commerciaux à long et à court terme à un niveau stratégique.

Une feuille de route technologique comprend généralement :

Les objectifs de l’entreprise ou d’équipe

Les nouvelles capacités du système

Les plans de publication pour chaque outil

Les étapes à atteindre

Les ressources nécessaires

La formation nécessaire

Les facteurs de risque ou obstacles potentiels à considérer

Examens des rapports d’état

Plusieurs équipes et parties prenantes sont généralement impliquées dans la feuille de route technologique, de l’informatique aux responsables généraux, en passant par les équipes de produit, de projet, des opérations, de l’ingénierie, de finances, des ventes, marketing et aux aspects juridiques.

La feuille de route permet à chacun de s’aligner et de comprendre comment les différentes tâches et responsabilités liées à la mise en œuvre impactent leur productivité.

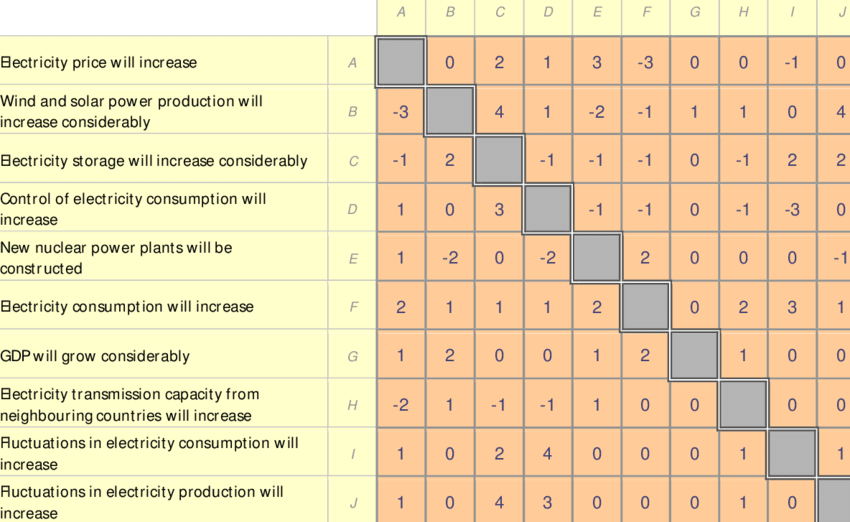

Analyse des Impacts Croisés

L’analyse d’impact croisé est le nom général donné à une famille de techniques conçues pour évaluer les changements dans la probabilité d’occurrence d’un ensemble donné d’événements consécutifs à l’occurrence réelle de l’un d’entre eux. Le modèle d’impact croisé a été introduit comme moyen de prendre en compte les interactions entre un ensemble de prévisions, lorsque ces interactions n’ont peut-être pas été prises en compte lors de l’élaboration de prévisions individuelles.

L’analyse des impacts croisés est principalement utilisée dans les études prospectives et de prévision technologique plutôt que dans les exercices de prospective en soi. Dans le passé, cet outil était utilisé comme méthode de simulation et en combinaison avec la méthode Delphi.

Les étapes décrites dans cette section sont valables pour différentes variantes de l’analyse d’impact croisé. Les étapes nécessaires à la mise en œuvre de la méthode SMIC (développée en France en 1974 par Duperrin et Godet) qui s’appuie sur un logiciel dédié, sont décrites ici.

La liste des événements à étudier peut également être établie avec le soutien d’experts sur la question sélectionnée, ou peut provenir d’autres méthodes utilisées pour recueillir des avis, comme la méthode Delphi.

Conception de l’échelle de probabilité et définition de l’horizon temporel : La définition d’une échelle de probabilité est nécessaire pour traduire l’appréciation qualitative des experts sur le degré d’occurrence (par exemple le plus probable, le plus probable, etc.) en probabilités. En général, l’échelle de probabilité des méthodes à impact croisé va généralement de 0 (événement impossible) à 1 (événement presque certain).

Estimation des probabilités : dans cette étape, la probabilité initiale d’occurrence de chaque événement est estimée. Ensuite, les probabilités conditionnelles dans une matrice d’impact croisé sont estimées en réponse à la question suivante : « Si l’événement x se produit, quelle est la nouvelle probabilité que l’événement j se produise ? L’ensemble de la matrice des impacts croisés est complété en posant cette question pour chaque combinaison d’événement survenu et d’événement impacté. Le SMIC a pour objectif de permettre de vérifier la cohérence des estimations des experts. La méthode SMIC invite les experts à répondre à une grille aux questions suivantes :

• la probabilité d’occurrence de chaque événement unique à un horizon temporel donné

• les probabilités conditionnelles de l’événement séparé pris par paires à un horizon temporel donné :

• P (i/j) probabilité de i si j se produit

• P (i /pas j) probabilité de i si j ne se produit pas

Génération de scénarios : Le résultat de l’application d’un modèle à impacts croisés est une production de scénarios.

Quelle que soit la manière dont la question de l’attribution des probabilités est résolue dans des modèles spécifiques à impact croisé, la procédure habituelle consiste à effectuer une simulation de Monte Carlo (Martino et Chen, 1978). Chaque exécution du modèle produit un historique futur synthétique, ou scénario, qui inclut l’occurrence de certains événements et la non-occurrence d’autres.

Le modèle est donc exécuté suffisamment de fois (soit environ 100 dans la version SMIC), pour que l’ensemble des scénarios de sortie représente un échantillon statistiquement valide des scénarios possibles que le modèle pourrait produire.

ans un modèle à n événements, des scénarios possibles « 2 à la puissance n » sont générés, chacun se différenciant de tous les autres par la survenance d’au moins un événement. Par exemple, s’il y a 10 événements à considérer, il y a 1024 scénarios possibles à estimer.

Une fois les matrices d’impacts croisés calculées, il est possible de réaliser une analyse de sensibilité. L’analyse de sensibilité consiste à sélectionner une estimation de probabilité initiale ou une estimation de probabilité conditionnelle, sur laquelle existe une incertitude. Ce jugement est modifié et la matrice est réexécutée. Si des différences significatives apparaissent entre cette analyse et celle d’origine, il apparaît alors que le jugement modifié joue un rôle important. Il serait peut-être utile de reconsidérer ce jugement particulier.

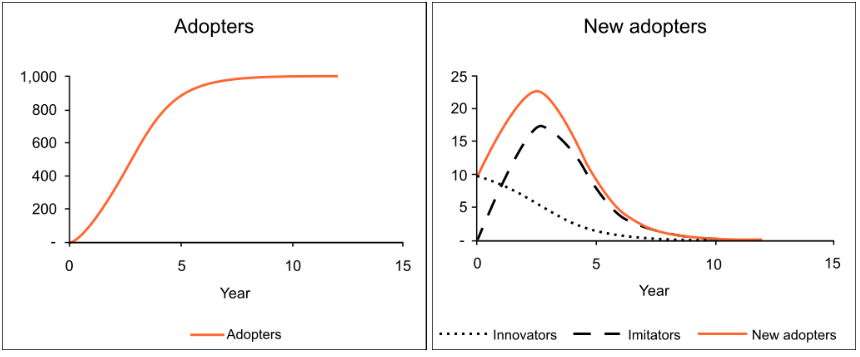

Diffusion de Bass

Le modèle Bass ou modèle de diffusion Bass a été développé par Frank Bass. Il s’agit d’une simple équation différentielle qui décrit le processus par lequel les nouveaux produits sont adoptés par une population. Le modèle présente une justification de la façon dont les adoptants actuels et les adoptants potentiels d’un nouveau produit interagissent. Le principe de base du modèle est que les adoptants peuvent être classés comme innovateurs ou imitateurs, et que la vitesse et le calendrier de l’adoption dépendent de leur degré d’innovation et du degré d’imitation parmi les adoptants.

Le modèle Bass a été largement utilisé dans les prévisions, en particulier dans la prévision des ventes de nouveaux produits et la prévision technologique. Mathématiquement, la diffusion de base de Bass est une équation de Riccati avec des coefficients constants équivalents à la croissance Verhulst-Pearl Logistic.

En 1969, Frank Bass a publié son article sur un nouveau modèle de croissance des produits de consommation durable. Auparavant, Everett Rogers avait publié Diffusion of Innovations, un ouvrage très influent décrivant les différentes étapes de l’adoption d’un produit. Bass a apporté quelques idées mathématiques au concept. Alors que le modèle Rogers décrit les quatre étapes du cycle de vie du produit (Introduction, Croissance, Maturité, Déclin), le modèle Bass se concentre sur les deux premières (Introduction et Croissance). Certaines extensions Bass-Model présentent des modèles mathématiques pour les deux derniers (maturité et déclin).

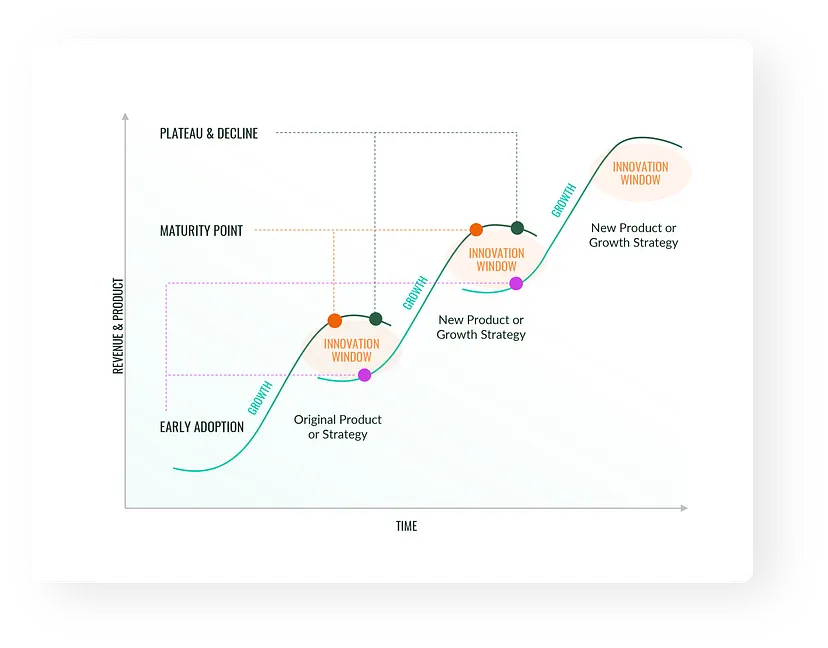

Courbe en S

Si vous examinez toutes les révolutions technologiques des dernières décennies, vous constaterez qu’elles ont toutes tendance à suivre un comportement similaire, appelé courbe en S.

- Au début, la technologie s’avère coûteuse, encombrante et peu adoptée . Les améliorations semblent lentes à mesure que les concepts fondamentaux sont compris (pensez aux premières automobiles, par exemple. Le développement a commencé en 1672, et ce n’est qu’en 1769 que la première automobile à vapeur capable de transporter des humains a été créée.).

- Ensuite, il y a généralement une période d’innovation rapide et d’expansion des fonctionnalités, entraînant une adoption massive (c’est à ce moment-là que les moteurs et les voitures sont devenus meilleurs et moins chers, plus attrayants qu’un cheval et une charrette et que presque tout le monde en achetait un).

- Ensuite, à mesure que le marché mûrit, les améliorations significatives ont tendance à ralentir et il n’y a plus beaucoup de nouveaux clients à qui vendre. Nous avons atteint le sommet de la courbe en S qui est saturée.

Désormais, une toute nouvelle technologie avec sa propre courbe en S peut prendre le dessus . Cela se voit dans les voitures (émergence des véhicules électriques), les avions ou d’autres inventions.

Modélisation par Agents

Faire un jumeaux numérique par modélisation multi-agent est très complexe. Nous vous invitons à voir notre cours sur le Multi-Agent de notre site complex-system-ai.com