Contenus de la page

ToggleGenerated Knowledge, le prompt nourrit le prompt

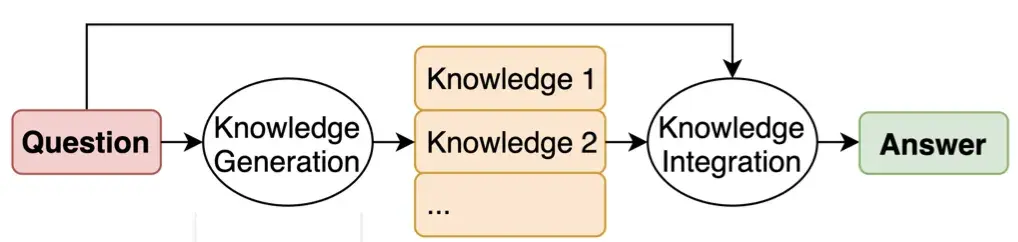

L’idée derrière l’approche des connaissances générées (generated knowledge) est de demander au LLM de générer des informations potentiellement utiles sur une question/invite donnée avant de générer une réponse finale.

Fonctionnement général

Le contenu ci-dessous couvre le contexte plus technique dans lequel l’approche a été introduite. Il suit le modèle des deux étapes intermédiaires (génération et intégration des connaissances) que nous avons vu ci-dessus.

Dans l’étape de génération de connaissances, le LLM est invité à générer un ensemble de faits sur la question. Le LLM est invité à répondre en quelques étapes (few-shot prompting), comme indiqué ci-dessous. M complétions différentes sont générées à l’aide de cette même invite (de manière similaire à l’approche d’auto-cohérence).

Ensuite, nous générons des questions « à connaissances augmentées » et incitons le LLM à obtenir des réponses finales. La façon la plus simple de comprendre cela est de passer par un exemple.

Supposons que nous essayons de répondre à la question « La plupart des kangourous ont des membres <mask> ». Supposons qu’à l’étape de génération de connaissances, nous ayons généré 2 connaissances (M=2) :

Connaissance 1 : Les kangourous sont des marsupiaux qui vivent en Australie.

Connaissance 2 : Les kangourous sont des marsupiaux qui ont 5 membres.

Maintenant, nous enchaînons chaque connaissance avec la question pour générer des questions à connaissances augmentées :

Question à connaissances augmentées 1 : La plupart des kangourous ont des membres <mask>. Les kangourous sont des marsupiaux qui vivent en Australie.

Question à connaissances augmentées 2 : La plupart des kangourous ont des membres <mask>. Les kangourous sont des marsupiaux qui ont 5 membres.

Nous posons ensuite au LLM ces questions enrichies en connaissances et obtenons les propositions de réponses finales :

Réponse 1 : 4

Réponse 2 : 5

Nous sélectionnons la réponse avec la probabilité la plus élevée comme réponse finale. La probabilité la plus élevée peut être la probabilité softmax du jeton de réponse ou la probabilité logarithmique du ou des jetons de réponse.

Approche des connaissances générées par une invite unique

Par exemple, imaginons que vous souhaitiez écrire un petit article de blog sur un animal, comme les ours Spirit. Avant de demander au LLM d’écrire l’article de blog, vous pouvez lui demander de générer des informations sur les ours Spirit. Cela aidera le LLM à rédiger un article de blog plus informatif. Il existe deux façons simples de procéder.

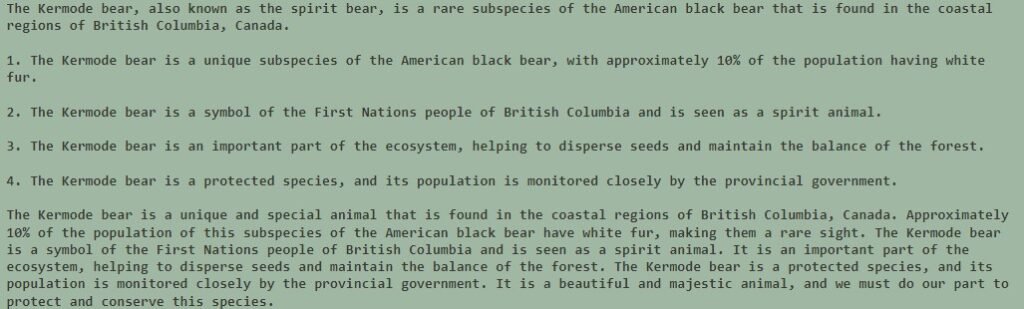

La première approche demande au LLM de générer des connaissances, puis de rédiger le message, le tout avec une seule invite.

Generate 4 facts about the Kermode bear, then use these facts to write a short blog post using the information:

Voici la réponse :

Approche à double invite

Dans cette approche, nous invitons d’abord le LLM à générer des faits sur l’ours :

Generate 4 facts about the Kermode bear:

Ensuite, nous introduisons ces informations dans une autre invite pour rédiger l’article de blog :

1. The Kermode bear, also known as the Spirit Bear, is a rare subspecies of the American black bear found in British Columbia, Canada. 2. The Kermode bear has a unique white or cream-colored coat, which is caused by a recessive gene. 3. The Kermode bear is a symbol of hope and renewal for the First Nations people of British Columbia. 4. The Kermode bear is a protected species and is listed as a species of special concern by the Committee on the Status of Endangered Wildlife in Canada. Use the above facts to write a one paragraph blog post about the Kermode bear:

Génération de connaissance pour la résolution logique

L’approche des connaissances générées a en fait été introduite pour une tâche complètement différente, celle de répondre à des questions difficiles. Considérez la question suivante, à laquelle le LLM répond incorrectement :

Si nous demandons d’abord au LLM de générer des faits sur le Congo et l’Afrique du Sud, nous pouvons ensuite utiliser ces informations pour répondre correctement à la question. En théorie, cela est similaire à l’incitation CoT, puisque nous demandons effectivement au LLM de générer un raisonnement intermédiaire sous la forme de faits connexes.

Commençons par la première étape, la génération de connaissances. Nous pouvons demander au LLM de générer des faits sur le Congo et l’Afrique du Sud :

Ensuite, utilisons ces connaissances pour répondre correctement à la question. C’est l’étape d’intégration des connaissances :

Génération pour décomposer le problème (CoT)

Voici un exemple ou la génération de connaissance permet de décomposer le problème et donc de répondre à la question :

Donc le prompt suivant, le llm garde en mémoire la décomposition du problème, et va donc vérifier les différents points cités lors de sa réponse :