Contenus de la page

ToggleLeast-to-Most Prompting, diviser pour mieux régner

L’invite de commande du moins au plus (least-to-most prompting) peut être combinée avec d’autres techniques d’incitation telles que la chaîne de pensée et l’auto-cohérence. Pour certaines tâches, les deux étapes de l’invite du moins au plus peuvent être fusionnées pour former une invite en un seul passage.

Décomposer le problème initial

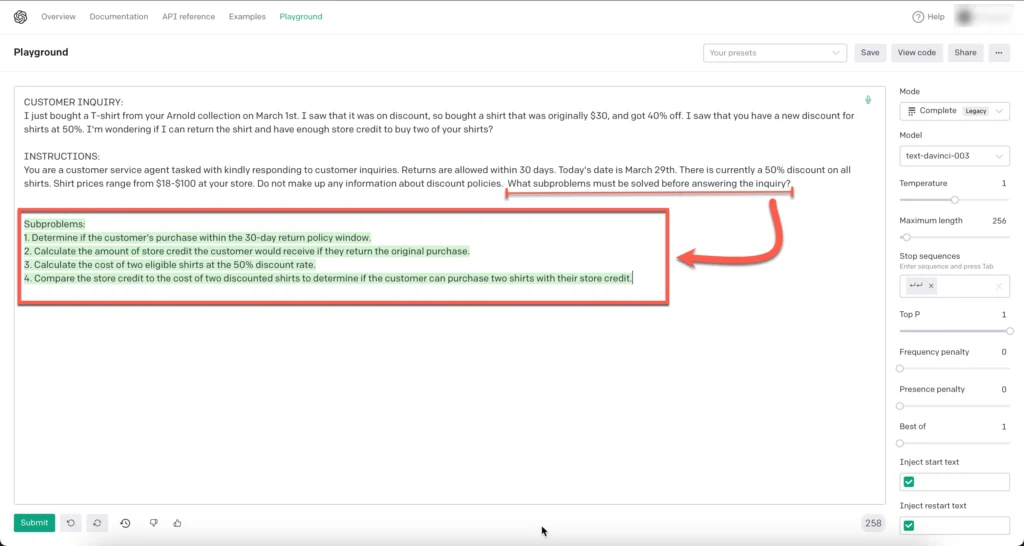

Voici un exemple pratique :

CUSTOMER INQUIRY: I just bought a T-shirt from your Arnold collection on March 1st. I saw that it was on discount, so bought a shirt that was originally $30, and got 40% off. I saw that you have a new discount for shirts at 50%. I'm wondering if I can return the shirt and have enough store credit to buy two of your shirts? INSTRUCTIONS: You are a customer service agent tasked with kindly responding to customer inquiries. Returns are allowed within 30 days. Today's date is March 29th. There is currently a 50% discount on all shirts. Shirt prices range from $18-$100 at your store. Do not make up any information about discount policies. Determine if the customer is within the 30-day return window.

Il renvoie la mauvaise réponse comme indiqué ci-dessous, lorsqu’il est directement demandé :

L’approche la plus simple à la plus rapide est suivie et illustrée dans le terrain de jeu OpenAI.

La séquence suivie consiste à poser d’abord au modèle (pour des raisons de cohérence, nous utilisons plusieurs invites) la question suivante :

What subproblems must be solved before answering the inquiry?

Par la suite, le LLM génère 4 sous-problèmes qui doivent être résolus pour que l’instruction soit terminée.

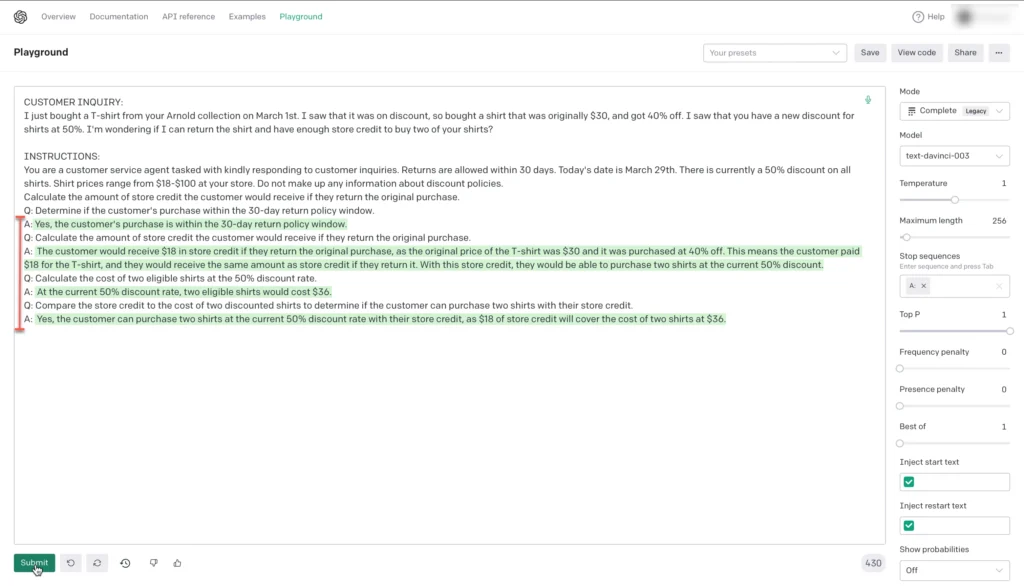

Décomposer le problème par étapes

En suivant l’approche du moins au plus, le LLM est invité à répondre aux quatre sous-problèmes ou tâches qu’il a identifiés.

Cependant, les sous-problèmes sont posés un par un, et le problème et la réponse précédents sont inclus dans l’invite. Par conséquent, l’invite est construite sur une question/réponse ou un sous-problème à la fois.

Les invites précédentes sont incluses à titre de référence et servent à un objectif de formation en quelques étapes.

Le scénario présenté au LLM peut être considéré comme ambigu, mais le LLM fait un travail remarquable en suivant la séquence et en atteignant la bonne réponse.

Il est aussi possible de décomposer chaque étape par un prompt distinct. Cela permettra au LLM de donner de plus ample explication sur son processus de réponse.